Se denomina inteligencia artificial (IA) a la rama de las Ciencias de la Computación[1] [2] [3] dedicada al desarrollo de agentes racionales no vivos.

Para explicar la definición anterior, entiéndase a un agente como cualquier cosa capaz de percibir su entorno (recibir entradas), procesar tales percepciones y actuar en su entorno (proporcionar salidas), y entiéndase a la [racionalidad] como la característica que posee una elección de ser correcta, más específicamente, de tender a maximizar un resultado esperado (este concepto de racionalidad es más general y por ello más adecuado que inteligencia para definir la naturaleza del objetivo de esta disciplina).

Por lo tanto, y de manera más específica la inteligencia artificial es la disciplina que se encarga de construir procesos que al ser ejecutados sobre una arquitectura física producen acciones o resultados que maximizan una medida de rendimiento determinada, basándose en la secuencia de entradas percibidas y en el conocimiento almacenado en tal arquitectura.

Existen distintos tipos de conocimiento y medios de representación del conocimiento. El cual puede ser cargado en el agente por su diseñador o puede ser aprendido por el mismo agente utilizando técnicas de aprendizaje.

También se distinguen varios tipos de procesos válidos para obtener resultados racionales, que determinan el tipo de agente inteligente. De más simples a más complejos, los cinco principales tipos de procesos son:

- Ejecución de una respuesta predeterminada por cada entrada (análogas a actos reflejos en seres vivos).

- Búsqueda del estado requerido en el conjunto de los estados producidos por las acciones posibles.

- Algoritmos genéticos (análogo al proceso de evolución de las cadenas de ADN).

- Redes neuronales artificiales (análogo al funcionamiento físico del cerebro de animales y humanos).

- Razonamiento mediante una lógica formal (análogo al pensamiento abstracto humano).

También existen distintos tipos de percepciones y acciones, pueden ser obtenidas y producidas, respectivamente por sensores físicos y sensores mecánicos en máquinas, pulsos eléctricos u ópticos en computadoras, tanto como por entradas y salidas de bits de un software y su entorno software.

Varios ejemplos se encuentran en el área de control de sistemas, planificación automática, la habilidad de responder a diagnósticos y a consultas de los consumidores, reconocimiento de escritura, reconocimiento del habla y reconocimiento de patrones. Los sistemas de IA actualmente son parte de la rutina en campos como economía, medicina, ingeniería y la milicia, y se ha usado en gran variedad de aplicaciones de software, juegos de estrategia como ajedrez de computador y otros videojuegos.

Escuelas de pensamiento

La IA se divide en dos escuelas de pensamiento:

- La inteligencia artificial convencional

- La inteligencia computacional

Inteligencia artificial convencional

Se conoce también como IA simbólico-deductiva. Está basada en el análisis formal y estadístico del comportamiento humano ante diferentes problemas:

- Razonamiento basado en casos: Ayuda a tomar decisiones mientras se resuelven ciertos problemas concretos y aparte que son muy importantes requieren de un buen funcionamiento.

- Sistemas expertos: Infieren una solución a través del conocimiento previo del contexto en que se aplica y ocupa de ciertas reglas o relaciones.

- Redes bayesianas: Propone soluciones mediante inferencia estadística.

- Inteligencia artificial basada en comportamientos: que tienen autonomía y pueden auto-regularse y controlarse para mejorar.

- Smart process management: facilita la toma de decisiones complejas, proponiendo una solución a un determinado problema al igual que lo haría un especialista en la actividad.

Inteligencia artificial computacional

La Inteligencia Computacional (también conocida como IA subsimbólica-inductiva) implica desarrollo o aprendizaje interactivo (por ejemplo, modificaciones interactivas de los parámetros en sistemas conexionistas). El aprendizaje se realiza basándose en datos empíricos.

Historia

- Las ideas más básicas se remontan a los griegos, antes de Cristo. Aristóteles (384-322 a. C.) fue el primero en describir un conjunto de reglas que describen una parte del funcionamiento de la mente para obtener conclusiones racionales, y Ktesibios de Alejandría (250 a. C.) construyó la primera máquina autocontrolada, un regulador del flujo de agua (racional pero sin razonamiento).

- En 1315 Ramon Llull en su libro Ars magna tuvo la idea de que el razonamiento podía ser efectuado de manera artificial.

- En 1936 Alan Turing diseña formalmente una Máquina universal que demuestra la viabilidad de un dispositivo físico para implementar cualquier cómputo formalmente definido.

- En 1943 Warren McCulloch y Walter Pitts presentaron su modelo de neuronas artificiales, el cual se considera el primer trabajo del campo, aun cuando todavía no existía el término. Los primeros avances importantes comenzaron a principios de los años 1950 con el trabajo de Alan Turing, a partir de lo cual la ciencia ha pasado por diversas situaciones.

- En 1955 Herbert Simon, Allen Newell y J.C. Shaw, desarrollan el primer lenguaje de programación orientado a la resolución de problemas, el IPL-11. Un año más tarde desarrollan el LogicTheorist, el cual era capaz de demostrar teoremas matemáticos.

- En 1956 fue inventado el término inteligencia artificial por John McCarthy, Marvin Minsky y Claude Shannon en la Conferencia de Dartmouth, un congreso en el que se hicieron previsiones triunfalistas a diez años que jamás se cumplieron, lo que provocó el abandono casi total de las investigaciones durante quince años.

- En 1957 Newell y Simon continúan su trabajo con el desarrollo del General Problem Solver (GPS). GPS era un sistema orientado a la resolución de problemas.

- En 1958 John McCarthy desarrolla en el Instituto de Tecnología de Massachusetts (MIT), el LISP. Su nombre se deriva de LISt Processor. LISP fue el primer lenguaje para procesamiento simbólico.

- En 1959 Rosenblatt introduce el Perceptrón.

- A fines de los 50 y comienzos de la década del 60 Robert K. Lindsay desarrolla «Sad Sam», un programa para la lectura de oraciones en inglés y la inferencia de conclusiones a partir de su interpretación.

- En 1963 Quillian desarrolla las redes semánticas como modelo de representación del conocimiento.

- En 1964 Bertrand Raphael construye el sistema SIR (Semantic Information Retrieval) el cual era capaz de inferir conocimiento basado en información que se le suministra. Bobrow desarrolla STUDENT.

- Posteriormente entre los años 1968-1970 Terry Winograd desarrolló el sistema SHRDLU, que permitía interrogar y dar órdenes a un robot que se movía dentro de un mundo de bloques.

- A mediados de los años 60, aparecen los sistemas expertos, que predicen la probabilidad de una solución bajo un set de condiciones. Por ejemplo DENDRAL, iniciado en 1965 por Buchanan, Feigenbaum y Lederberg, el primer Sistema Experto, que asistía a químicos en estructuras químicas complejas euclidianas, MACSYMA, que asistía a ingenieros y científicos en la solución de ecuaciones matemáticas complejas.

- En 1968 Minsky publica Semantic Information Processing.

- En 1968 Seymour Papert, Danny Bobrow y Wally Feurzeig, desarrollan el lenguaje de programación LOGO.

- En 1969 Alan Kay desarrolla el lenguaje Smalltalk en Xerox PARC y se publica en 1980.

- En 1973 Alain Colmenauer y su equipo de investigación en la Universidad de Aix-Marseille crean PROLOG (del francés PROgrammation en LOGique) un lenguaje de programación ampliamente utilizado en IA.

- En 1973 Shank y Abelson desarrollan los guiones, o scripts, pilares de muchas técnicas actuales en Inteligencia Artificial y la informática en general.

- En 1974 Edward Shortliffe escribe su tesis con MYCIN, uno de los Sistemas Expertos más conocidos, que asistió a médicos en el diagnóstico y tratamiento de infecciones en la sangre.

- En las décadas de 1970 y 1980, creció el uso de sistemas expertos, como MYCIN: R1/XCON, ABRL, PIP, PUFF, CASNET, INTERNIST/CADUCEUS, etc. Algunos permanecen hasta hoy (shells) como EMYCIN, EXPERT, OPSS.

- En 1981 Kazuhiro Fuchi anuncia el proyecto japonés de la quinta generación de computadoras.

- En 1986 McClelland y Rumelhart publican Parallel Distributed Processing (Redes Neuronales).

- En 1988 se establecen los lenguajes Orientados a Objetos.

- En 1997 Garry Kasparov, campeón mundial de ajedrez pierde ante la computadora autónoma Deep Blue.

- En 2006 se celebró el aniversario con el Congreso en español 50 años de Inteligencia Artificial - Campus Multidisciplinar en Percepción e Inteligencia 2006.

- En el año 2009 ya hay en desarrollo sistemas inteligentes terapéuticos que permiten detectar emociones para poder interactuar con niños autistas.

- Existen personas que al dialogar sin saberlo con un chatbot no se percatan de hablar con un programa, de modo tal que se cumple la prueba de Turing como cuando se formuló: «Existirá Inteligencia Artificial cuando no seamos capaces de distinguir entre un ser humano y un programa de computadora en una conversación a ciegas».

- Como anécdota, muchos de los investigadores sobre IA sostienen que «la inteligencia es un programa capaz de ser ejecutado independientemente de la máquina que lo ejecute, computador o cerebro».

[editar] Fundamentos y filosofía

Como ocurre casi siempre en el caso de una ciencia recién creada, la inteligencia artificial aborda tantas cuestiones confundibles en un nivel fundamental y conceptual que, adjunto a lo científico, es necesario hacer consideraciones desde el punto de vista de la filosofía. Gran parte de esta ciencia se junta con temas en la filosofía de la mente, pero hay ciertos temas particulares a la IA. Por ejemplo:

- ¿En qué consiste la inteligencia? ¿Cómo la reconoceríamos en un objeto no humano, si la tuviera?

- ¿Qué sustancia y organización se requiere? ¿Es posible que una criatura hecha de metal, por ejemplo, posea una inteligencia comparable a la humana?

- Aunque una criatura no orgánica pudiera solucionar problemas de la misma manera que un humano, ¿tendría o podría tener conciencia y emociones?

- Suponiendo que podemos hacer robots con una inteligencia comparable a la nuestra, ¿debemos hacerlo?

Durante más de 2000 años de tradición en filosofía, han ido surgiendo diversas teorías del razonamiento y del aprendizaje, simultáneamente con el punto de vista de que la mente se reduce al funcionamiento físico. La psicología ofrece herramientas que permiten la investigación de la mente humana, así como un lenguaje científico para expresar las teorías que se van obteniendo. La lingüística ofrece teorías para la estructura y significado del lenguaje, así como la ciencia de la computación, de la que se toman las herramientas que permiten que la Inteligencia Artificial sea una realidad.

Empezó con el nacimiento de Platón en 428 a. C. y con lo que aprendió de Sócrates. La temática de su obra fue muy diversa: política, matemática, física, astronomía y diversas ramas de la filosofía. El filósofo Hubet Dreyfus (1979) afirma que:

Los filósofos delimitaron las más importantes ideas relacionadas con la inteligencia artificial, pero para pasar de allí a una ciencia formal era necesario contar con una formalización matemática en tres áreas principales: la computación, la lógica y la probabilidad. La idea de expresar un cálculo mediante un algoritmo formal se remonta a la época de Jwarizmi, matemático árabe del siglo IX, con cuyas obras se introdujeron en Europa los números arábigos y el álgebra (de su nombre al-Jwarizmi deriva la palabra algoritmo).

El hombre se ha aplicado a sí mismo el nombre científico de Homo sapiens como una valoración de la trascendencia de nuestras habilidades mentales tanto para nuestra vida cotidiana como para nuestro propio sentido de identidad. Los esfuerzos del campo de la inteligencia artificial se enfocan en lograr la compresión de entidades inteligentes. Una de las razones de su estudio es el aprender más de nosotros mismos. A diferencia de la filosofía y de la psicología, que también se ocupan de la inteligencia, los esfuerzos de la inteligencia artificial están encaminados tanto a la construcción de entidades como a su compresión. Otra razón por la cual se estudia la inteligencia artificial es debido a que ha sido posible crear sorprendentes y diversos productos de trascendencia. Nadie podría pronosticar con toda precisión lo que se podría esperar en el futuro, es evidente que las computadoras que posean una inteligencia a nivel humano tendrán repercusiones muy importantes en nuestra vida diaria así como en el devenir de la civilización.

El problema que aborda la inteligencia artificial es uno de los más complejos: ¿Cómo es posible que un diminuto y lento cerebro, sea biológico o electrónico, tenga capacidad de percibir, comprender, predecir y manipular un mundo que en tamaño y complejidad lo excede con creces?, pero a diferencia de la investigación en torno al desplazamiento mayor que la velocidad de la luz o de un dispositivo antigravitatorio, el investigador del campo de la inteligencia artificial cuenta con pruebas contundentes de que tal búsqueda es totalmente factible.

La inteligencia artificial permite al hombre emular en las máquinas el comportamiento humano, tomando como base el cerebro y su funcionamiento, de manera tal que se pueda alcanzar cierto razonamiento creando marionetas robóticas.

La inteligencia artificial y los sentimientos

El concepto de IA es aún demasiado difuso. Contextualizando, y teniendo en cuenta un punto de vista científico, podríamos englobar a esta ciencia como la encargada de imitar una persona, y no su cuerpo, sino imitar al cerebro, en todas sus funciones, existentes en el humano o inventadas sobre el desarrollo de una máquina inteligente.

A veces, aplicando la definición de Inteligencia Artificial, se piensa en máquinas inteligentes sin sentimientos, que «obstaculizan» encontrar la mejor solución a un problema dado. Muchos pensamos en dispositivos artificiales capaces de concluir miles de premisas a partir de otras premisas dadas, sin que ningún tipo de emoción tenga la opción de obstaculizar dicha labor.

En esta línea, hay que saber que ya existen sistemas inteligentes. Capaces de tomar decisiones «acertadas».

Aunque, por el momento, la mayoría de los investigadores en el ámbito de la Inteligencia Artificial se centran sólo en el aspecto racional, muchos de ellos consideran seriamente la posibilidad de incorporar componentes «emotivos» como indicadores de estado, a fin de aumentar la eficacia de los sistemas inteligentes.

Particularmente para los robots móviles, es necesario que cuenten con algo similar a las emociones con el objeto de saber –en cada instante y como mínimo– qué hacer a continuación [Pinker, 2001, p. 481].

Al tener «sentimientos» y, al menos potencialmente, «motivaciones», podrán actuar de acuerdo con sus «intenciones» [Mazlish, 1995, p. 318]. Así, se podría equipar a un robot con dispositivos que controlen su medio interno; por ejemplo, que «sientan hambre» al detectar que su nivel de energía está descendiendo o que «sientan miedo» cuando aquel esté demasiado bajo.

Esta señal podría interrumpir los procesos de alto nivel y obligar al robot a conseguir el preciado elemento [Johnson-Laird, 1993, p. 359]. Incluso se podría introducir el «dolor» o el «sufrimiento físico», a fin de evitar las torpezas de funcionamiento como, por ejemplo, introducir la mano dentro de una cadena de engranajes o saltar desde una cierta altura, lo cual le provocaría daños irreparables.

Esto significa que los sistemas inteligentes deben ser dotados con mecanismos de retroalimentación que les permitan tener conocimiento de estados internos, igual que sucede con los humanos que disponen de propiocepción, interocepción, nocicepción, etcétera. Esto es fundamental tanto para tomar decisiones como para conservar su propia integridad y seguridad. La retroalimentación en sistemas está particularmente desarrollada en cibernética, por ejemplo en el cambio de dirección y velocidad autónomo de un misil, utilizando como parámetro la posición en cada instante en relación al objetivo que debe alcanzar. Esto debe ser diferenciado del conocimiento que un sistema o programa computacional puede tener de sus estados internos, por ejemplo la cantidad de ciclos cumplidos en un loop o bucle en sentencias tipo do... for, o la cantidad de memoria disponible para una operación determinada.

A los sistemas inteligentes el no tener en cuenta elementos emocionales les permite no olvidar la meta que deben alcanzar. En los humanos el olvido de la meta o el abandonar las metas por perturbaciones emocionales es un problema que en algunos casos llega a ser incapacitante. Los sistemas inteligentes, al combinar una memoria durable, una asignación de metas o motivación, junto a la toma de decisiones y asignación de prioridades con base en estados actuales y estados meta, logran un comportamiento en extremo eficiente, especialmente ante problemas complejos y peligrosos.

En síntesis, lo racional y lo emocional están de tal manera interrelacionados entre sí, que se podría decir que no sólo no son aspectos contradictorios sino que son –hasta cierto punto– complementarios.

Críticas

Las principales críticas a la inteligencia artificial tienen que ver con su incapacidad de imitar por completo a un ser humano. Estas críticas ignoran que ningún humano individual tiene capacidad para resolver todo tipo de problemas, y autores como Howard Gardner han propuesto que existen inteligencias múltiples. Un sistema de inteligencia artificial debería resolver problemas. Por lo tanto es fundamental en su diseño la delimitación de los tipos de problemas que resolverá y las estrategias y algoritmos que utilizará para encontrar la solución.

En los humanos la capacidad de resolver problemas tiene dos aspectos: los aspectos innatos y los aspectos aprendidos. Los aspectos innatos permiten por ejemplo almacenar y recuperar información en la memoria y los aspectos aprendidos el saber resolver un problema matemático mediante el algoritmo adecuado. Del mismo modo que un humano debe disponer de herramientas que le permitan solucionar ciertos problemas, los sistemas artificiales deben ser programados de modo tal que puedan resolver ciertos problemas.

Muchas personas consideran que el test de Turing ha sido superado, citando conversaciones en que al dialogar con un programa de inteligencia artificial para chat no saben que hablan con un programa. Sin embargo, esta situación no es equivalente a un test de Turing, que requiere que el participante esté sobre aviso de la posibilidad de hablar con una máquina.

Otros experimentos mentales como la Habitación china de John Searle han mostrado cómo una máquina podría simular pensamiento sin tener que tenerlo, pasando el test de Turing sin siquiera entender lo que hace. Esto demostraría que la máquina en realidad no está pensando, ya que actuar de acuerdo con un programa preestablecido sería suficiente. Si para Turing el hecho de engañar a un ser humano que intenta evitar que le engañen es muestra de una mente inteligente, Searle considera posible lograr dicho efecto mediante reglas definidas a priori.

Uno de los mayores problemas en sistemas de inteligencia artificial es la comunicación con el usuario. Este obstáculo es debido a la ambigüedad del lenguaje, y apareció ya en los inicios de los primeros sistemas operativos informáticos. La capacidad de los humanos para comunicarse entre sí implica el conocimiento del lenguaje que utiliza el interlocutor. Para que un humano pueda comunicarse con un sistema inteligente hay dos opciones: o bien el humano aprende el lenguaje del sistema como si aprendiese a hablar cualquier otro idioma distinto al nativo, o bien el sistema tiene la capacidad de interpretar el mensaje del usuario en la lengua que el usuario utiliza.

Un humano durante toda su vida aprende el vocabulario de su lengua nativa. Un humano interpreta los mensajes a pesar de la polisemia de las palabras utilizando el contexto para resolver ambigüedades. Sin embargo, debe conocer los distintos significados para poder interpretar, y es por esto que lenguajes especializados y técnicos son conocidos solamente por expertos en las respectivas disciplinas. Un sistema de inteligencia artificial se enfrenta con el mismo problema, la polisemia del lenguaje humano, su sintaxis poco estructurada y los dialectos entre grupos.

Los desarrollos en inteligencia artificial son mayores en los campos disciplinares en los que existe mayor consenso entre especialistas. Un sistema experto es más probable de ser programado en física o en medicina que en sociología o en psicología. Esto se debe al problema del consenso entre especialistas en la definición de los conceptos involucrados y en los procedimientos y técnicas a utilizar. Por ejemplo, en física hay acuerdo sobre el concepto de velocidad y cómo calcularla. Sin embargo, en psicología se discuten los conceptos, la etiología, la psicopatología y cómo proceder ante cierto diagnóstico. Esto dificulta la creación de sistemas inteligentes porque siempre habrá desacuerdo sobre lo que se esperaría que el sistema haga. A pesar de esto hay grandes avances en el diseño de sistemas expertos para el diagnóstico y toma de decisiones en el ámbito médico y psiquiátrico (Adaraga Morales, Zaccagnini Sancho, 1994).

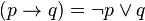

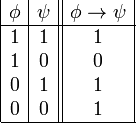

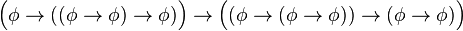

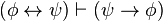

es una fórmula bien formada de L, entonces

es una fórmula bien formada de L, entonces  también lo es.

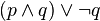

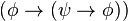

también lo es. son fórmulas bien formadas de L, entonces

son fórmulas bien formadas de L, entonces  ,

,  ,

,  y

y  también lo son.

también lo son.

![\begin{array}{rcl} \left\langle \mbox{Bicondicional}\right\rangle & ::= & \left\langle \mbox{Condicional}\right\rangle \leftrightarrow\left\langle \mbox{Bicondicional}\right\rangle \mid\left\langle \mbox{Condicional}\right\rangle \\ \left\langle \mbox{Condicional}\right\rangle & ::= & \left\langle \mbox{Conjuncion}\right\rangle \rightarrow\left\langle \mbox{Condicional}\right\rangle \mid\left\langle \mbox{Conjuncion}\right\rangle \\ \left\langle \mbox{Conjuncion}\right\rangle & ::= & \left\langle \mbox{Disyuncion}\right\rangle \vee \left\langle \mbox{Conjuncion}\right\rangle \mid\left\langle \mbox{Disyuncion}\right\rangle \\ \left\langle \mbox{Disyuncion}\right\rangle & ::= & \left\langle \mbox{Literal}\right\rangle \wedge\left\langle \mbox{Disyuncion}\right\rangle \mid\left\langle \mbox{Literal}\right\rangle \\ \left\langle \mbox{Literal}\right\rangle & ::= & \left\langle \mbox{Atomo}\right\rangle \mid\neg\left\langle \mbox{Atomo}\right\rangle \\ \left\langle \mbox{Atomo}\right\rangle & ::= & \top\mid\bot\mid\left\langle \mbox{Letra}\right\rangle \mid\left\langle \mbox{Agrupacion}\right\rangle\\ \left\langle \mbox{Agrupacion}\right\rangle & ::= & (\left\langle \mbox{Bicondicional}\right\rangle )\mid[\left\langle \mbox{Bicondicional}\right\rangle ]\mid\{\left\langle \mbox{Bicondicional}\right\rangle \} \end{array}](http://upload.wikimedia.org/math/6/7/9/67948e7cc33c6c17a71c807a4ab1b04c.png)

)

) )

)

sería:

sería: